Data Quality

Für effiziente Prozesse braucht es eine hochwertige Datenbasis

Bringen Sie Ihre Kundendaten auf höchstes Niveau

Die Grundlage und die Voraussetzung für optimierte Abläufe in einem Unternehmen sind glaubwürdige und belastbare Unternehmensdaten. Eine hohe Datenqualität beschleunigt Ihre Geschäftsprozesse und verschafft Ihnen einen nicht zu unterschätzenden Wettbewerbsvorteil.

Das Optimum für Ihre Daten.

Um das Beste aus Ihren Daten herauszuholen, müssen Sie sie verstehen, pflegen, schützen und überwachen. Und das im Sinne eines effizienten Data Quality Managements über den gesamten Data Quality Lifecycle. Für die Bewältigung dieser Aufgaben bieten wir Ihnen eine Kombination aus leistungsstarken Tools und erfahrenen Beratern.

Unsere Data Quality Lösungen fügen sich in Ihre IT-Struktur ein und erfüllen punktgenau Ihre Anforderungen. So gewährleisten Sie, dass Ihre Daten stets den Anforderungen des Business genügen und minimieren das Risiko von Data Management Projekten jeglicher Art. Bei der Optimierung Ihrer Geschäftspartnerdaten ist es unser Anspruch, Ihnen höchste Ergebnisqualität in bester Performance zu bieten.

Wir bieten Ihnen die beste Qualität

- Data Quality Lösungen aus einer Hand.

- Support durch erfahrene Berater und 50+ Jahre Erfahrung.

- Gewährleistung der geforderten Datenqualität.

- Lauffähigkeit auf allen gängigen Plattformen.

- Kostenoptimierung durch Hybridlösungen.

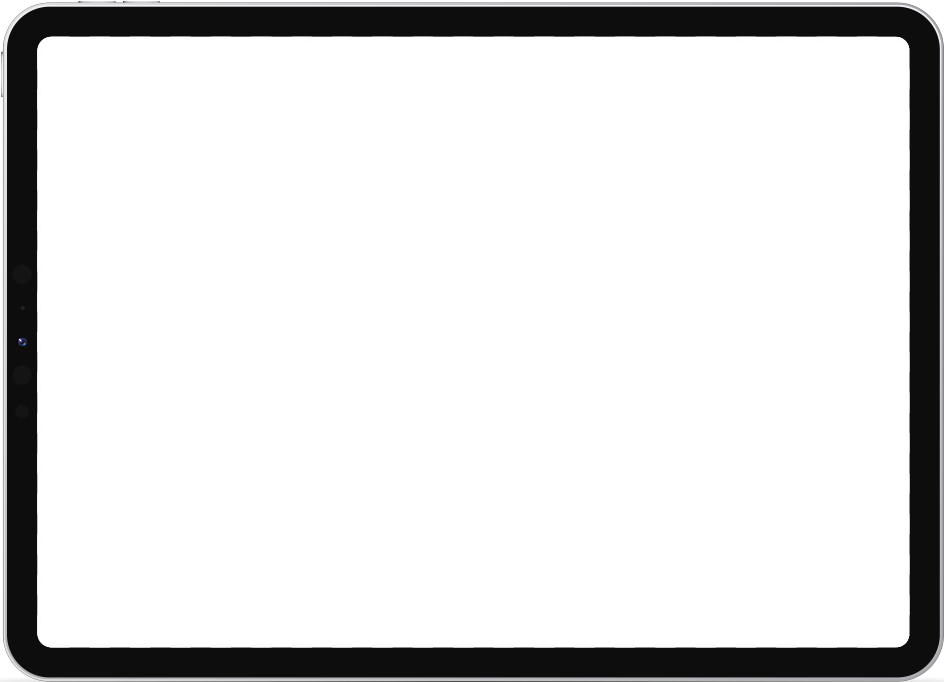

Testen Sie unsere Data Quality Tools

In Uniserv CONNECT können Sie unsere Data Quality Services in der Cloud unkompliziert und kostenfrei testen. Prüfen Sie interaktiv Adress-, Kontakt-, Firmen- und Bankdaten. Das erwartet Sie:

- 100 freie Requests. Alle Services ausführlich & kostenlos testen.

- API-Dokumentation. Alle Details zu Integration & Schnittstellen.

- Entdecken & ausprobieren. Anschauliche Beispiele unterschiedlicher Use Cases.

- Fragen? Unsere Experten stehen für Sie bereit.

Mit perfekten & qualitativ hochwertigen Kundenstammdaten zum Erfolg

In vielen Unternehmensbereichen wie Vertrieb, Marketing und Finance spielen Daten eine Schlüsselrolle. Mit unseren maßgeschneiderten Data Quality Lösungen machen Sie Ihre Kundenstammdaten zum Erfolgsfaktor Ihres Unternehmens:

- Wir sorgen für eine hohe Datenqualität an jedem Ort in Ihrem Unternehmen – auch international.

- Wir bieten Ihnen die Korrektur der Adressinformationen basierend auf exzellenten Referenzdaten.

- Wir prüfen E-Mail-Adressen, Telefonnummern oder Bankdaten auf verschiedenen Ebenen.

- Wir werten Ihre Stammdaten auf – beispielsweise durch die Anreicherung mit Geokoordinaten oder Branchenschlüssel.

Sollten Sie Redundanzen in Ihren Daten haben, suchen wir sehr flexibel und unter Berücksichtigung Ihrer Geschäftsregeln nach Dubletten. Diese können regelbasiert weitestgehend automatisch konsolidiert oder für die manuelle Nachbearbeitung ausgesteuert werden.

Mit der Uniserv Software verfügen Sie über eine hochwertige Datenbasis, die Ihren Ansprüchen gerecht wird. Das steigert nicht nur die Effizienz Ihrer Mitarbeiter, auch die Unternehmensprozesse laufen reibungsloser ab und Sie agieren erfolgreicher am Markt. Und das zeigt sich schließlich auch in Ihren Unternehmenszahlen.

Die vier Stufen der Datenqualität

Wir zeigen Ihnen vier Steps, die bei der Qualität der Daten beachtet werden müssen, damit sie am Ende zum echten Asset für Ihr Unternehmen gelten. Für Ihre Daten nur das Beste.

Laden Sie sich jetzt das Uniserv Business Whitepaper herunter.

Top-Unternehmen vertrauen auf Data Quality Software von Uniserv

Wir sind für Sie da.

Kontaktieren Sie uns über das Formular oder rufen Sie uns direkt an.

FAQs

In Gesprächen mit unseren Kunden und Mitarbeitern aus den unterschiedlichen Fachabteilungen werden uns immer wieder ähnliche Symptome schlechter Datenqualität genannt. Aus den Symptomen lassen sich Anhaltspunkte für konkrete Data-Quality-Initiativen ableiten, so dass sich erste Hinweise für die Erstellung des Maßnahmenkatalogs ergeben:

- Kunden und Geschäftspartner tauchen mehrfach im System auf

- Ansprechpartner sind nicht aktuell

- Hohe Rückläuferquote bei Mailing-Aktionen aufgrund falscher oder unvollständiger Adressen

- Kundenbeschwerden bei Mehrfachzustellung der gleichen Werbesendungen

- Geringe Response-Raten bei Marketing-Aktionen

- Falsche Briefanreden und Adresszeilen, wenn z. B. Herr Katrin Müller und Frau Walter Schmitt Post von Ihnen bekommen

- Cross- und Up-Selling-Möglichkeiten sind nicht zu erkennen

- Geringe Benutzerakzeptanz und Beschwerden der Mitarbeiter

- Gesetzliche Vorgaben können nicht eingehalten werden

- Mangelnde Planungssicherheit: Strategische Entscheidungen werden nur mit großer Unsicherheit gefällt

Direkt vorab: Fehlerhafte Adressen und mangelhafte Datenqualität sind ein Kostenfaktor, den Unternehmen einfach vermeiden könnten!

In Deutschland ändern sich jährlich durch Umzüge etwa 14 Millionen Adressen und durch Sterbefälle etwa 990.000. Viele der insgesamt 370.000 Hochzeiten und 150.000 Scheidungen pro Jahr sind mit Namensänderungen verbunden. Hinzu kommen jährlich tausende Änderungen bei Straßennamen, Postleitzahlen und Orten. Die meisten Änderungen geschehen bei der Anschrift – das CRM ist nicht zwingend up-to-date.

Postalisch einwandfreie Adressen sind für Unternehmen von zentraler Bedeutung. Denn nur korrekte Anschriften sichern die Zustellbarkeit der Aussendungen, minimieren Porto- und Werbeausgaben und sind für die Ermittlung von Dubletten unverzichtbare Voraussetzung. Lesen Sie in unserem Paper „Was kosten schlechte Daten?“, wann Daten schlecht sind, welche vermeidbaren Kosten sie ganz konkret verursachen, und wie Sie diese Kosten künftig vermeiden können.

Es geht darum Datenqualität zu verbessern und laufend zu managen. Das ist keine Einmalaufgabe, denn fast alle Daten in Unternehmen, Kundendaten zumal, unterliegen ständigen Veränderungen. Ziel muss es deshalb sein, sicherzustellen, dass Kundeninformationen konstant einheitlich, vollständig und aktuell vorliegen. Dennoch verbessern Unternehmen ihre Datenqualität meist nur phasenweise, weil etwa ein neues Projekt einen Anlass dazu bietet (und entsprechende Budgets zur Verfügung stehen). Im Anschluss wird die Qualität aber meist wieder schlechter. Das liegt in der Natur der Sache, denn Daten ändern sich durch neue Gegebenheiten, beispielsweise durch die Änderung der Mobilfunknummer oder der Adresse.

Ist die Rede von einem Management der Datenqualität, handelt es sich um eine Vorgehensweise, die die Qualität der Daten über den gesamten Lebenszyklus der Daten hinweg sicherstellt - von der Erfassung über ihre Speicherung und Nutzung bis zu ihrer Archivierung und Löschung. Zum Einsatz kommt dabei gemeinhin der Regelkreisansatz ("closed loop") aus dem Total Quality Management. Zu Beginn werden die Kundendaten bereits während der Datenerfassung mittels DQ-Services geprüft. Fehlerhafte Kundendaten, die nicht automatisch bereinigt werden können, werden in einer Zwischendatenbank gespeichert und ein Bericht oder Alert an die Eingabestelle geschickt, so dass diese korrigierend eingreifen kann.

Mit diesem Kreislauf lassen sich Kundendaten kontinuierlich während der Erfassung und Bearbeitung überprüfen. Werden über diese Prozesse regelmäßig Berichte verfasst (etwa über ein Data Quality Dashboard), können Anwender die Leistung des geschlossenen Regelkreises für das Datenqualitäts-Management messen (Performance Management) und den Prozess kontinuierlich verbessern. Das Ergebnis ist eine nahezu konstante Datenqualität auf hohem Niveau.

Datenqualität hört an dieser Stelle aber nicht auf. Unternehmen sind überwiegend so strukturiert, dass das DQ-Management einen übermäßigen Aufwand erzeugt, weil die Datenhoheit meist bei den Abteilungen liegt. So können unterschiedliche Abteilungen oder neu erschlossene Geschäftsfelder nicht auf alle Kundendaten im Unternehmen zugreifen. Die Datentöpfe passen nicht zusammen. Das Management der Datenqualität bleibt in solchen Konstellationen auf voneinander getrennte Systemsilos beschränkt. Diese beherbergen zwar eine Menge an Kundendaten, die durch Zusammenführung mit unternehmensweit verfügbaren Daten in ihrer Qualität verbessert und angereichert werden könnten. Doch de facto verursachen die bestehenden Strukturen und Prozesse hohe Kosten durch Redundanzen.

Und was noch schwerer wiegt: Unternehmen verspielen das große Potenzial, das in ihren Datenbanken liegt - nämlich die Chance auf eine einheitliche Sicht auf ihre Kunden. Die Realität ist ernüchternd, denn den Unternehmen fehlt es an Überblick und ihr Management kann sich kaum auf die Daten als Basis für Entscheidungen und Maßnahmen verlassen. Fehlentscheidungen und Fehlinvestitionen können die teure Folge sein. Die Notwendigkeit für Datenqualität ist offensichtlich. Damit der Erfolg eines umfassenden Datenqualitäts-Managements aber tatsächlich auf die tägliche Arbeit der Mitarbeiter und den Geschäftserfolg des gesamten Unternehmens durchschlägt, ist ein Master Data Management notwendig.

Unabhängig von ihrer Struktur und Organisation, sollten Unternehmen bei der Überprüfung ihrer Datenqualität Schritt für Schritt vorgehen. Zunächst müssen zwei Bereiche, die eng miteinander verflochten sind, bewertet werden: Die Qualität der Daten und die damit verbundenen Prozesse. Da Daten in Geschäftsprozessen genutzt werden, beschreiben Prozesse ihren Verwendungszweck und geben das notwendige Datenformat vor. Liegen etwa qualifizierte Leads in einer Excel-Tabelle (Format) vor und sollen für Mailings eingesetzt werden (Prozess), muss das Format entsprechend angepasst werden. Dazu gehört, dass Datenfelder ergänzt, angereichert und so kodiert werden, dass sie für das Mailing-Tool importfähig sind. Dementsprechend hat jeder Prozess Einfluss auf die Datenqualität. In der Praxis ist der Verwendungszweck von Daten und somit der weitere Prozess vielen Mitarbeitern häufig gar nicht bekannt; der Mangel an Bewusstsein dafür sorgt allein schon für Fehler.

1. Symptome und Ursachen erkennen

Anhaltspunkte einer jeden Datenqualitätsbewertung sind Symptome, die analysiert werden müssen. Beklagen Mitarbeiter beispielsweise einen hohen manuellen Rechercheaufwand oder Nacharbeit bei der Erstellung von Kundenlisten, müssen diese Klagen als Symptome erkannt werden. Die Ursache kann in der fehlenden Aktualität von Daten liegen oder in fehlendem Vertrauen der Mitarbeiter in die Daten. Während nun also von unzureichender Datenqualität auszugehen ist, muss auch überprüft werden, ob bestehende Prozesse darauf Einfluss nehmen.

Ein anderes Beispiel ist das mehrfache Auftauchen von Kunden und Geschäftspartnern in datenführenden Systemen (Dubletten). Die Analyse der Prozesse kann hier etwa ergeben, dass Mitarbeiter vor dem Anlegen neuer Kunden nicht überprüfen, ob diese schon im System vorhanden sind.

Um Symptomen und Ursachen auf die Spur zu kommen, sind möglichst Mitarbeiter, die regelmäßig mit den Daten arbeiten, in den Prozess mit einzubeziehen. Aus den jeweiligen Symptomen und Ursachen ergeben sich die zu analysierenden Datenobjekte und -prozesse. Zudem können und sollten die Verantwortlichen daraus ableiten, wie Unternehmensstammdaten aussehen müssen, damit sie alle damit arbeitenden Mitarbeiter effizient nutzen können.

2. Profiling

Nun gilt es, das "Bauchgefühl" und Erfahrungswissen der Mitarbeiter zum Status der Datenqualität durch Analyseergebnisse zu belegen. Ziel ist es, den Status Quo der Daten aufzuzeigen und eine fundierte Aussage über Vollständigkeit, Korrektheit und Redundanz der Daten zu treffen. Das Ergebnis dieses Profilings sollte folgende Fragen beantworten:

- Welche Informationen fehlen?

- Wo tauchen verdächtige Ausreißer auf?

- Wo passt das Format nicht zur Bedeutung?

- Wo sind zwei oder mehrere Attribute nicht konsistent?

- Wo werden vorgegebene Regeln verletzt?

- In welchem Kontext treten Fehler auf?

- Wie stellt sich ein Fehler in unterschiedlichen Datensegmenten dar (verschiedene Regionen, unterschiedliche Erfassungszeiträume etc.)?

- Wie verändert sich das Auftreten von Fehlern im Lauf der Zeit?

Um diese Fragen zu beantworten, empfiehlt sich der Einsatz von Software, die automatisiert nach Lücken, Fehlern und Zusammenhängen innerhalb eines Datenbestands sucht, diese zusammenträgt und damit die Grundlage für das Analyseergebnis liefert.

Das Data Profiling ist ein entscheidender Schritt - übergehen Unternehmen diesen Punkt, was häufig der Fall ist, treffen sie ihre Maßnahmen zur Verbesserung der Datenqualität auf gut Glück. Denn wenn die Verantwortlichen ihre Datengrundlage nicht eindeutig kennen, veranlassen sie Maßnahmen nach Bauchgefühl, gehen aber nicht allen Ursachen nach. Als Folge bleiben ihre Daten unzuverlässig und Mitarbeiter müssen weiterhin holprige Prozesse und schlechte Datenqualität hinnehmen.

Was glauben Sie: Wie gut sind eigentlich Ihre Daten? Wenn es um die Qualität der eigenen Daten geht, sollte man sich nicht nur auf ein vages Bauchgefühl verlassen. Wie machen Sie das Ganze also messbar? Das Uniserv Data Assessment schafft hier Abhilfe: wir verschaffen uns einen exakten Überblick über den aktuellen Zustand Ihrer Daten und bewerten sie nach standardisierten Datenqualitätskriterien.

3. Maßnahmenkatalog erstellen

Auf Basis des Profilings werden Maßnahmen festgelegt, die die Daten- und Prozessqualität auf höchstes Niveau bringen. Das kann sein, den Verwendungszweck von Daten sowie die Anforderungen an sie festzuschreiben oder einen Real-Time-Adress-Check einzuführen. Möchte man Dubletten in den Griff bekommen, könnte eine Echtzeit-Dublettenprüfung die Lösung sein. Die Bandbreite der möglichen Maßnahmen ist - genauso wie die der Anforderungen an Daten und Prozesse - groß und hängt immer vom jeweiligen Fall ab.

4. Bereinigen & Prozesse anpassen

In jedem Fall muss das Unternehmen seinen untersuchten Datenbestand bereinigen, also fehlerhafte Daten entfernen und korrigieren. Dies kann beispielsweise die automatisierte Überprüfung von Telefonnummern sein - eine wichtige Maßnahme und Unterstützung für CRM-Projekte, den Helpdesk, Beschwerdemanagement oder andere Aufgaben des Kundenkontaktmanagements. Dort werden Dubletten automatisch beseitigt.

Neben der Bereinigung der Daten müssen häufig Prozesse wie auch Systemlandschaften angepasst werden. Sind alle Bereiche entsprechend justiert, hat die Datenqualität im Idealfall das maximal erreichbare Niveau. Ob es konstant bleibt, hängt indes vom weiteren Daten- und Qualitäts-Management im gesamten Unternehmen ab.

Das könnte Sie auch interessieren: